Компанія Google опублікувала алгоритм, що дозволяє відстежувати рухи руки на смартфонах з великою точністю. Розробники вважають, що це дозволить реалізувати на смартфонах нові функції, наприклад, розпізнавання жестової мови або жестові команди. Алгоритм доступний як у вигляді програмного коду на GitHub, так і у вигляді додатку для Android, а подробиці про нього компанія розповіла в своєму блозі.

Розпізнавання пози – одна з класичних задач алгоритмів комп’ютерного зору, що має безліч застосувань, причому як корисних, так і розважальних. Наприклад, розпізнавання пози тіла використовують для визначення насильницьких дій в натовпі.

На сьогоднішній день існує безліч реалізацій алгоритму відстеження пози, причому як для всього тіла, так і для окремих частин, наприклад, обличчя або рук. Багато з них мають відкритий вихідний код і доступні для використання. Однак майже всі ці алгоритми використовують в своїй роботі нейромережеві моделі, що вимагають великої обчислювальної потужності і через це непридатні на мобільних пристроях.

Програмісти з Google створили відкриту реалізацію алгоритму відстеження положення руки, адаптовану для роботи на мобільних пристроях. На початку алгоритм аналізує кадри з камери і виявляє на них руку, після чого працює тільки з потрібною областю, що значно знижує вимоги до потужності пристрою.

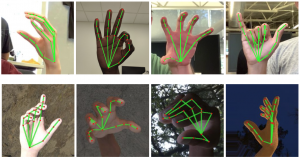

Під час роботи алгоритм створює модель руки, що складається з 21 точки, яких достатньо для відносно точного опису положення руки в конкретний момент. Алгоритм працює в двох режимах: в одному він створює двовимірну модель руки, а в іншому – тривимірну. На основі такого алгоритму розробники також створили і систему розпізнавання жестів: отримуючи модель руки, алгоритм аналізує кути між частинами пальців і зіставляє їх з базою відомих йому жестів.

За інформацією N+1